告别“低水平内卷”,云计算步入“黄金时代”

告别“低水平内卷”,云计算步入“黄金时代”

2024 年注定是云计算发展的关键时间节点。

过去两年多时间里,云计算行业被讨论最多的话题就是 " 降价 ",在市场增速放缓,甚至有企业高呼 " 下云 " 的背景下,云厂商纷纷打出了 " 价格牌 ",导致整个行业陷入到了 " 低水平内卷 " 的境地。

进入 2024 年后,在大模型的促进下,千行万业的智能化转型愈演愈烈,而云化算力作为灵活高效、性价比极高的算力资源获取方式,正在成为各 AI 厂商新的算力底座。如果说芯片是智能时代的 " 石油 ",那云化算力就是 AI 发展的 " 新能源 "。

新旧业态的转变,对云计算的影响绝不仅仅是舆论层面,属于云计算的 " 黄金时代 " 或许才刚刚开始。

01

云计算的 " 第二增长曲线 "

生成式 AI 正在席卷千行万业,想要拿到通往新时代的船票," 上云 " 可以说是第一选择。生成式 AI 需要云计算,也为云计算提供了新的驱动力。

直接的例子就是坐上 OpenAI" 副驾驶 " 的微软。

4 月 25 日,微软发布了 2024 财年第三财季的财报,微软云业务的整体收入为 351 亿美元,同比增长 23%;智能云业务部门收入达到 267 亿美元,同比增长 21%,其中 Azure 和其他云服务的收入增长 31%,AI 对 Azure 的收入贡献提升至 7%,高于 2024 财年第二财季的 6% 和第一财季的 3%。

人工智能释放出的增长推动力,让华尔街的分析师们普遍对微软持有乐观态度。券商 Wedbush 的知名科技分析师 Daniel Ives 直言:" 未来 6 到 12 个月内,人工智能用例可能会在整个企业领域呈爆炸式增长。我们将此视为微软的’ iPhone 时刻’,人工智能将改变微软未来几年的云增长轨迹,我们对此充满信心。"

一个礼拜前结束的 WWDC 2024,进一步印证了这样的趋势。

从苹果公布的 AI 战略来看,全场最大的亮点莫过于和 ChatGPT 的整合:用户可以呼唤 Siri,以及在全系统的写作工具中调用 ChatGPT,实现聊天机器人、图像生成等功能,且这些需求会上传到 OpenAI 的数据中心,在云端完成。也就意味着,AI 推理将长期以 " 云端为主 ",至少是三到五年中的常态。

事实上,国内市场也早有准备。

比如华为云在 2023 年 9 月上线的昇腾云服务,除了满足基础的 AI 算力需求,还提供了高效长稳的大模型训练环境和完备的工具链,千亿参数行业模型的端到端开发,从过去的 5 个月缩短到了 1 个月。

同样做出选择的还有大模型厂商。有别于 2023 年初疯狂囤芯片的景象,越来越多的大模型厂商开始在云上训练和推理。比如估值超过 25 亿美元的 MiniMax,没有购买任何 GPU,而是以相对便宜的价格租赁云算力。

不只是云厂商和大模型厂商,走在 AI 第一线的大中型企业,也已经将 AI 和云作为战略方向。

借用奇瑞汽车股份有限公司副总经理戴闯的说法:" 预计未来 5 年智能网联汽车将超过 90% 的渗透率,将累计上万 PB 的数据量。汽车行业的数据价值挖掘不充分,所以奇瑞认为以 AI 推动的创新是必然之路,基于云服务的自动驾驶数据闭环平台,围绕算力、算法、数据构建了端到端的 AI 底座。"

如果将资源上云、应用上云看作是云计算的 " 第一增长曲线 ",急剧增长的生成式 AI 需求,将为云计算带来 " 第二增长曲线 ",在基础资源需求逐渐饱和时,为云计算行业开辟了新的增量市场。

02

云上 AI 成为 " 最大公约数 "

必须回答的一个问题是:满足算力需求的方式有很多,譬如自建算力中心的方式,为什么大大小小的企业要选择云上 AI 算力呢?

似乎有必要回顾下互联网的商业简史。

在 PC 互联网初期,一台服务器就足以撑起一个网站。到了移动互联网时代,智能手机的普及进一步扩充了网民群体,形成了一个又一个月活上亿的超级应用。正是在这一时期,云计算开始走进人们的视线,提供了一种比传统机房更灵活、更弹性的资源获取方式。

移动互联网的商业模式是 " 以终端为中心 " 的,智能手机的保有量某种程度上就是移动互联网的上限。而生成式 AI 的特征是 " 以智能为中心 ",借助自然语言的交互范式,手机、电视、汽车、空调等任何终端都可以是交互入口,算力需求注定会爆炸性增长。

" 计算 " 量的指数级增长,也带来了建设周期、运维、散热等一系列挑战。

以大模型训练为例,通常需要数千张 GPU,基于 TB 级别的数据,耗时几个月进行训练。一旦出现硬件故障、电源中断、数据传输问题,训练过程可能会被打断,导致长时间的等待和之前计算资源的浪费。

无法绕开的还有算力中心的散热问题。AI 服务器的功率密度远超通用服务器,单机柜的功耗是过去的 6-8 倍。在 " 绿色数据中心 " 的政策限制下,需要专用的液冷系统进行散热,以降低 PUE(能效比)。

两相比较的话,云计算有着近乎 " 降维打击 " 的优势。

比如在算力交付方面,华为云芜湖数据中心在全球首创了机房产品化交付模式,将电力、AHU 制冷等模块化,把电缆管道预制化,可实现极速交付,并将交付过程中的质量问题降低了 90%;在运维层面引入 IOT 技术,实现了告警秒级上报、故障分钟级定位;在散热方面,华为云首创了云服务感知能效调优技术,AI 智能调优精度高达 99.5%,可使 PUE 降低 8% 到 15% ……

身为 " 局内人 " 的科大讯飞董事长刘庆峰,对此有着深刻认识:" 下一步我们还有更多任务要开发,更多算力要用,在我们自己建算力集群之后,我们发现在华为云上做训练推理建设比自己做更轻松、效率更高,更能满足短时瞬间的规模化算力应用之后,释放波峰波谷(减少能耗闲置,算力削峰填谷),对整个行业都是效率最高的。"

大模型及相关应用是迄今为止最复杂的软硬件系统工程,需要系统性创新才能应对。云上 AI 算力作为一种高效、灵活、可扩展的解决方案,无疑是打破算力瓶颈的最优解,并因此成为产业上下游的共识。

03

下半场将比拼 " 算力服务 "

云计算价值和演进方向的悄然变化,意味着游戏规则也将同步更新:不再是拼价格的 " 低水平内卷 ",而是进入比拼 " 算力服务 " 的新赛段。

其中的一个关键赛点在于,能否提供 " 无处不在 " 的算力服务以及全栈 AI 能力。

为何不少企业倾向于自建算力中心,原因之一就是对时延的苛刻要求。大模型训练时常常需要几个 TB 的数据传输,没有哪家企业甘愿被带宽和时延卡了脖子。况且大模型将有 90% 以上的算力需求用于推理,如果时延过长,将导致推理过程的延迟,直接影响响应效率和用户体验。

这也就成了云厂商们 " 卷 " 的新方向。

譬如 6 月 14 日正式开服的华为云华东(芜湖)数据中心,不仅标志着华为云全国存算网布局的全面完成,还画出了一个覆盖华东、华中等算力高地的 10ms 时延圈,时延圈内的对时延要求非常高的 AI 推理、电商、游戏等行业,都可以一键接入。

除了在物理上降低时延,通过多级恢复机制、完备的工具链等保障服务的连续性、稳定性,也是保障算力服务 " 无处不在 " 的思路。

以昇腾云服务为例,为大模型和 AI 应用的开发运行提供了资源获取快、模型迁移快、故障修复快等六大 AI 支撑能力,实现了模型训练一键接入多个算力中心、出现故障可以在 10 分钟内恢复、推理服务就近接入相应的 AI 算力中心等服务,保障 AI 企业在任何地方都能享受即开即用的澎湃算力。

另一个不应忽略的赛点是 " 解决行业难题 " 的能力。

拥有全栈 AI 能力的华为云,可以说是最早给出答案的云厂商之一。

而对于庞大中小企业的需求,华为云的全栈 AI 能力可提供从云化算力、模型开发、模型托管到生态的全栈服务,提供 ModelArts Standard(一站式 AI 开发服务)、ModelArts Lite(高性价比算力服务)等多种模式,帮助企业实现训推一体。

也就是说,华为云打造的 "AI 基建 " 能力覆盖了模型开发的全流程,企业无需投资通用 AI 技术,省去了在山路上摸爬滚打的时间可以直接上 AI 高速公路。

简单做个总结的话:相比上一次的红利期,生成式 AI 浪潮催生出的 " 蛋糕 " 更大,对云厂商的筛选也将更为严格。既需要先进的存算网络,有能力保障不断增长的算力需求,也需要在技术和模式上同步创新,真正帮助企业 " 解难题,做难事 ",让 AI 重塑千行万业。无数个带着问题和需求上云的客户,将加速向技术派云厂商转移。

04

写在最后

回到文初的话题,为什么说云计算的 " 黄金时代 " 才刚开始呢?

就现阶段而言,云计算的增长引擎已经从价格渠道逐步向需求驱动、价值驱动转变,势必会倒逼云厂商改变市场策略,将资源投入到核心领域,继而从 " 低水平内卷 " 重回理性增长的轨道。

把视角再放长远一些,AI 对云计算的 " 颠覆 " 才露出冰山一角,过去的云服务是以功能为中心的,譬如 CRM、客服系统、OA 等等。未来将是以场景为中心,基于大模型的能力,打破功能上的边界,深入场景解决问题。彼时,云计算将渐渐剥离资源属性,成为智能世界的 " 底层系统 "。

-

- 跨境电商急需“回血”

-

2024-06-23 02:36:15

-

- 李雪健:于海丹是我妻子,携手与共39年,导演儿子让一家人骄傲

-

2024-06-20 14:03:42

-

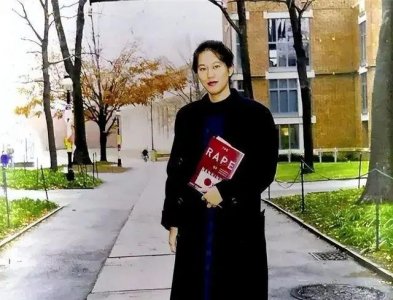

- 25年前她向全世界揭露“南京大屠杀”真相,7年后饮弹自尽年仅36岁,她叫张纯

-

2024-06-20 14:01:25

-

- 台州有个神仙居景区,风光梦幻迷人,因桥多而成为网红

-

2024-06-20 13:59:08

-

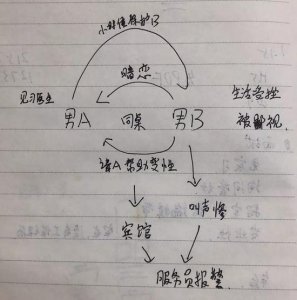

- 男子暗恋男同桌让其帮变性 睾丸被切致重伤

-

2024-06-20 13:56:52

-

- 赵又廷官宣高圆圆怀孕!日常羡慕两位神仙爱情的日子又到了

-

2024-06-20 13:54:35

-

- 还有人记得papi酱吗?

-

2024-06-20 13:52:19

-

- 解密 南派传销如何给人洗脑

-

2024-06-20 13:50:02

-

- 冤不冤?女律师在朋友圈炫富,却被截图发上网,遭全民扒皮

-

2024-06-20 13:47:46

-

- 他到哪都是大型圈粉现场

-

2024-06-20 13:45:30

-

- 湘琴嫁给“江直树”的第5年,分居两地、被传婚变,她真的幸福吗?

-

2024-06-20 13:43:13

-

- 禁止“手工补息”波及同业存单,一周发行大减248亿,银行压力陡增

-

2024-06-19 09:55:17

-

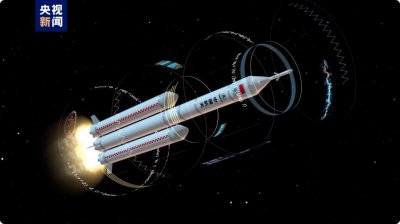

- 新一代载人登月火箭“新”在哪?可重复使用还拥有智慧大脑

-

2024-06-19 09:53:01

-

- 花上万请网红填志愿,就能保孩子的“好前途”?教育部出手了

-

2024-06-19 09:50:45

-

- 门店不到千家,茶颜悦色IPO传闻再起

-

2024-06-19 09:48:29

-

- 花呗花式劝学!网友晒证卷出新高度

-

2024-06-19 09:46:12

-

- 10年看快乐大本营这个桥段时觉得郑爽挺好的

-

2024-06-19 09:43:57

-

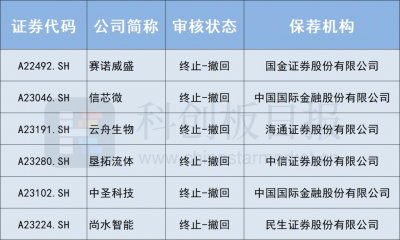

- 本周共6家企业IPO终止 新“国九条”后企业“撤单”数量增加

-

2024-06-19 09:41:41

-

- “517楼市新政”满月:政策效果逐步显现,更多支持在路上

-

2024-06-19 09:39:25

-

- 乌兰浩特警方破获50亿元医药领域虚开发票案 众生药业产品牵涉其中?公司人士:

-

2024-06-19 09:37:09

中国最脏的女明星排名(十大最不干净女明星)

中国最脏的女明星排名(十大最不干净女明星) 搬家时放个鸡蛋什么意思 搬家时放个鸡蛋什么意思呀

搬家时放个鸡蛋什么意思 搬家时放个鸡蛋什么意思呀